Wegweiser für Lehrkräfte im Umgang mit LLM-Chatbots

In einer zunehmend digitalisierten Welt ist der produktive Umgang mit KI-Systemen auch mit Blick auf die Schule von zentraler Bedeutung. Lehrkräfte können z.B. bei der Unterrichtsplanung oder der Materialerstellung auf vielfältige Weise von Künstlicher Intelligenz profitieren. Inwieweit das gelingt, liegt zu einem hohen Teil an den jeweiligen Prompts, mit denen ein KI-System wie ChatGPT, Microsoft Copilot, Claude etc. gezielt und effektiv angeleitet wird.

Was ist ein Prompt, was ist Prompt Engineering?

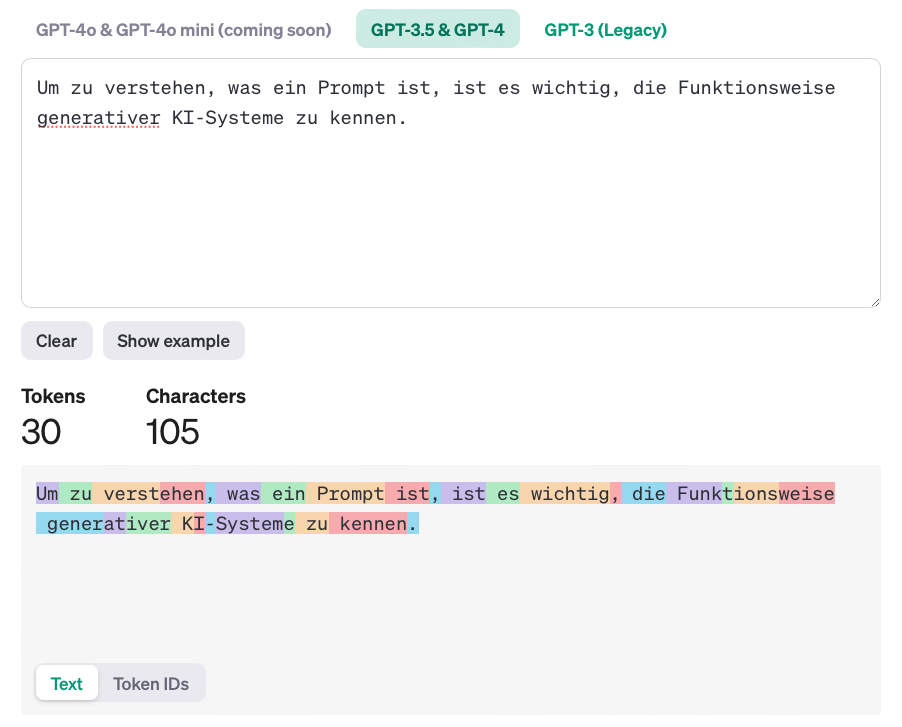

Um zu verstehen, was ein Prompt ist, ist es wichtig, die Funktionsweise generativer KI-Systeme zu kennen. Diese arbeiten wie Wahrscheinlichkeitsmaschinen, die bei jeder Anfrage Token (Wörter, Wortteile, Satzzeichen oder andere linguistische Einheiten) aus ihren umfangreichen Datensätzen kombinieren. Basierend auf den vorangegangenen Token und den zugrunde liegenden Wahrscheinlichkeiten erzeugen sie den Output, wie etwa einen neuen Text. Prompts sind die Eingabebefehle, die diesen algorithmischen Prozess steuern und beeinflussen. Prompt Engineering bezeichnet hingegen eine noch junge Disziplin, die darauf abzielt, Prompts so zu gestalten und zu optimieren, dass sie nicht nur bestmögliche Ergebnisse liefern, sondern auch das Verhalten der Sprachmodelle in spezifischen Kontexten gezielt lenken. So können die Potenziale und Grenzen von Sprachmodellen besser verstanden und genutzt werden.

Prompt-Arten: Ein Überblick

Beim Arbeiten mit KI-Systemen können viele verschiedene Arten von Prompts eingesetzt werden, je nach Zielsetzung und der Komplexität des gewünschten Outputs. Diese Prompt-Arten unterscheiden sich in ihrer Struktur und ihrem Anwendungsbereich:

- Zero-Shot/Single-Shot: Zero-Shot/Single-Shot Prompts sind die einfachste Form von Eingaben, bei denen eine einzelne, spezifische Anfrage an das KI-System gestellt wird, ohne dass zusätzliche Beispiele oder Kontext bereitgestellt werden. Diese Methode eignet sich besonders für einfache, direkt formulierte Aufgaben, bei denen keine komplexen Überlegungen erforderlich sind.

Beispiel: Erkläre das Konzept der Photosynthese für Schüler*innen der 8. Klasse.

- Few-Shot: Bei Few-Shot-Prompts werden dem KI-System mehrere Beispiele gegeben, die als Orientierung dienen und zeigen, welche Art von Antwort erwartet wird. Diese Beispiele helfen dem Modell, den gewünschten Output präziser zu erzeugen, indem es aus den bereitgestellten Mustern lernt.

Beispiel: Erstelle einen Grundlagen-Lückentext zum 1. Weltkrieg für eine achte Klasse mit zehn Lücken nach folgendem Muster: „Der erste Weltkrieg beginnt im Jahr -1- und endet im Jahr -2-„. Anmerkung: Die späteren Lücken sollen fortlaufend markiert werden. Gib die Lösung am Ende des Textes an.

- Chain-of-Thought Prompting: Diese Methode veranlasst das KI-System, seine Gedankengänge Schritt für Schritt zu entwickeln und darzulegen. Sie eignet sich besonders gut für komplexe Problemlösungen oder logische Aufgaben, bei denen eine klare, nachvollziehbare Argumentationskette erforderlich ist[1].

Beispiel: Warum führte das Attentat von Sarajevo zum Ausbruch des Ersten Weltkriegs? Bitte erkläre deine Gedanken in einzelnen Schritten.

- In-Context-Learning: In-Context Learning nutzt den unmittelbaren Textkontext innerhalb einer Sitzung/eines Chats, um die Qualität und Relevanz der generierten Antworten zu verbessern. Das Modell verwendet den Kontext der vorherigen Eingaben, um kohärente und thematisch passende Antworten zu geben (Erinnerungs-Funktion bei ChatGPT). Es ist wichtig zu beachten, dass die allermeisten Modelle sich nur an den Text innerhalb der aktuellen Eingabe erinnern und keinen Speicher über verschiedene Sitzungen hinweg haben.

- Iteratives Prompting: Iteratives Prompting bezieht sich auf einen dialogischen Prozess, bei dem der Prompt schrittweise verfeinert wird. Durch iterative Eingaben und die Analyse der erhaltenen Antworten wird der Prompt kontinuierlich angepasst, um das gewünschte Ergebnis zu erzielen. Dieser Ansatz ist besonders nützlich für komplexe Fragestellungen, bei denen es auf eine feine Abstimmung der Anweisungen ankommt.

Beispiel: Didaktische Planung einer Unterrichtsstunde zur Analyse der Ballade „Der Zauberlehrling“ von Johann Wolfgang von Goethe.

Szenario: Eine Deutschlehrerin plant eine Unterrichtsstunde, in der die Schüler*innen die Ballade „Der Zauberlehrling“ von Johann Wolfgang von Goethe analysieren sollen. Um den Unterricht strukturiert zu planen und verschiedene Aspekte der Analyse zu integrieren, verwendet sie iteratives Prompting.

Erste Eingabe: „Erstelle eine grobe Unterrichtsplanung für eine 90-minütige Stunde zur Analyse der Ballade „Der Zauberlehrling“. Die Stunde soll eine Einführung, die Analyse der Form und eine Interpretation der zentralen Motive umfassen.“

Verfeinerung: Nachdem die KI eine grobe Planung erstellt hat, gibt die Lehrerin einen weiteren Prompt ein: „Füge zur Analyse der Form konkrete Fragestellungen hinzu, die die Schüler*innen zur Metrik, dem Reimschema und dem Sprachrhythmus des Gedichts anleiten.“

Weiteres Feedback: Auf Grundlage der generierten Planung bittet die Lehrerin die KI: „Erweitere den Abschnitt zur Interpretation der zentralen Motive. Integriere dabei eine Diskussion über die Bedeutung des Motivs der „ungebändigten Macht“ und wie es sich im Verlauf des Gedichts entwickelt.“

Endgültige Überarbeitung: „Füge eine abschließende Reflexionsphase hinzu, in der die Schüler*innen die Relevanz des Textes für die heutige Zeit diskutieren. Berücksichtige dabei, wie die Thematik auf moderne technologische Entwicklungen übertragen werden könnte.“

- Multimodales Prompting: Diese Art von Prompting kommt zum Einsatz, wenn das KI-System nicht nur Text, sondern auch andere Datenformen wie Bilder, Audio oder Video verarbeiten kann. Hier wird der Prompt so gestaltet, dass das System Informationen über verschiedene Modi hinweg verarbeitet, was eine erweiterte Interaktion mit dem KI-System ermöglicht.

Beispiel: Die Deutschlehrerin möchte die Ballade „Der Zauberlehrling“ auch visuell darstellen. Prompt: „Erstelle basierend auf der Analyse ein Bild, das die zentrale Szene darstellt, in der die Situation außer Kontrolle gerät. Das Bild soll die Unruhe und das Chaos widerspiegeln, die durch die unkontrollierte Macht des Zauberlehrlings entstehen. Zeige die tanzenden Besen und das überflutete Zimmer, um das Chaos zu verdeutlichen.“

- Mega-Prompt/System-Prompt/Chain-Prompt: Diese fortgeschrittenen Techniken umfassen mehrstufige Anweisungen (Mega- oder System-Prompt) oder die Verknüpfung mehrerer Prompts (Chain-Prompt), um komplexe Aufgabenstellungen in logisch aufeinander aufbauende Schritte zu unterteilen. Durch diese Methode wird das KI-System schrittweise durch einen Prozess geführt, was es ermöglicht, umfangreiche und mehrstufige Aufgaben effektiv zu bearbeiten. Darüber hinaus kann eine spezifische KI-Verhaltenssteuerung bei weiteren Antworten innerhalb eines Dialoges erreicht werden. Derart komplexe Prompts lassen sich auch mit Techniken anderer Prompt-Arten kombinieren.

Beispiel für einen Mega-Prompt: Du bist ein Schreibtutor, der Schüler*innen hilft, das argumentierende Schreiben zu erlernen. Deine Aufgabe ist es, den Schüler*innen zu erklären, wie sie einen überzeugenden Aufsatz schreiben können, der eine These aufstellt und mit stichhaltigen Argumenten untermauert. Gehe Schritt für Schritt vor und gib Tipps/Beispiele. Fordere die Schüler*innen nach jedem Schritt auf, einen eigenen Text zu schreiben. Warte nach jedem Schritt auf die Antwort, gib anschließend Feedback, und gehe dann erst zum nächsten Schritt. Verwende eine einfache und verständliche Sprache, die für Schüler*innen der 8. Klasse geeignet ist. Achte darauf, den Prozess strukturiert zu erklären.

Schritt 1: **Einleitung**

Erkläre …

Schritt 2: **These aufstellen**

Forschung zum Prompting

Welche Prompt-Arten am effektivsten eingesetzt werden können, lässt sich mit einem Blick auf den „Prompt Report“ beantworten, einem systematischen Überblick über Prompting-Techniken (Schulhoff et al. 2024). Die Autor*innen weisen darauf hin, dass Few-Shot-Prompts in Kombination mit Chain-of-Thought-Anweisungen im Vergleich verschiedener Prompt-Arten zu den genauesten Ergebnissen führen. Darüber hinaus deutet die Studie „Many-Shot In-Context Learning“ von Google DeepMind (Agarwal et al. 2024) darauf hin, dass mehr Beispiele (hunderte bis zu tausende) innerhalb des Prompts noch effektiver seien als wenige Beispiele. Wer den Output noch weiter verbessern möchte, kann zudem auf die Technik des „Re-Reading“ (RE2) zurückgreifen. Hierbei wird laut einer Studie von Xu et al. (2024) das logische Denken von Sprachmodellen durch das erneutes Lesen einer Frage verbessert. Diese Technik steigert die Verarbeitungsqualität der Eingabe und verbessert die logische Schlussfolgerungsfähigkeit des LLM-Chatbots, insbesondere in Kombination mit anderen Ansätzen wie dem Chain-of-Thought-Prompting[2].

Beispiel: Ich bin Lehrer für Mathematik und möchte mit meinen Schülern folgende Aufgabe als Beispiel-Aufgabe bearbeiten.

„In einer Klasse sind 30 Schüler, davon sind 12 Mädchen. Wie viel Prozent der Klasse sind Mädchen?“

Lies die Frage erneut: „In einer Klasse sind 30 Schüler, davon sind 12 Mädchen. Wie viel Prozent der Klasse sind Mädchen?“

Überlege Schritt für Schritt, wie du diese Aufgabe im Mathematikunterricht erklären würdest. Wie muss hierbei der Dreisatz angewendet werden? Welche didaktischen Hilfsmittel könntest du einsetzen, um den Dreisatz und die Prozentrechnung für die Schüler nachvollziehbar zu machen?

Weitere Tipps

OpenAI gibt in ihrem Prompt-Engineering-Guide auch selbst Tipps für effektive Prompts. Interessant ist hierbei, dass neben Hinweisen auf das neueste Modell und klare Anweisungen/spezifische Beschreibungen auf die Verwendung von Hashtags (#), dreifachen Anführungszeichen (“““) und XML-Tags (<>) hingewiesen wird. Der Einsatz dieser Zeichen dient dem Trennen von Anweisung und Kontext, kennzeichnet Textabschnitte und erhöht die Maschinenlesbarkeit des Prompts (OpenAI 2024)[3].

Beispiel: Fasse mir den folgenden Absatz in einem zentralen Satz zusammen!

“““Text“““

Oder:

Fasse mir die wichtigsten Argumente der folgenden Texte in Stichpunkten zusammen! Vergleiche die beiden Texte anschließend miteinander.

<article>

Hier ist Text 1

</article>

<article>

Hier ist Text 2

</article>

Prompting-Frameworks

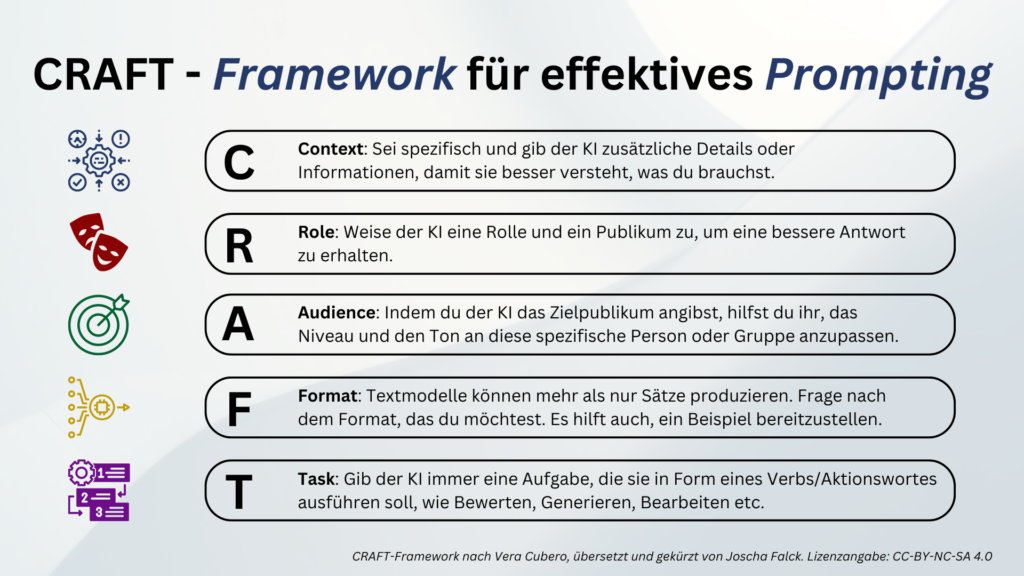

Auch wenn die verschiedenen Techniken logisch aufgebaut und die Empfehlungen nachvollziehbar sind, ist deren Umsetzung im Alltag schwierig, insbesondere wenn noch keine ausreichenden Routinen aufgebaut sind. Um dennoch schnell zu zielführenden Ergebnissen zu kommen, ist es sinnvoll, sich an sogenannten Prompting-Frameworks zu orientieren. Diese bieten strukturierte Ansätze, die dabei helfen, präzise Prompts zu erstellen. Hervorzuheben sind hierbei die Frameworks CRAFT (Vera Cubero) und PREP (Dan Fitzpatrick).

CRAFT-Framework nach Vera Cubero:

- Content: Festlegung des Inhalts, der im Output enthalten sein soll.

- Role: Definition der Rolle, die das KI-Modell übernehmen soll (z.B. Experte, Berater).

- Audience: Bestimmung der Zielgruppe des Outputs.

- Format: Vorgabe der gewünschten Struktur des Outputs (z.B. Liste, Aufsatz).

- Tone: Festlegung der gewünschten Stimmung oder des Tons (z.B. formell, informell).

PREP-Framework nach Dan Fitzpatrick:

- Prompt: Die eigene Absicht erklären.

- Role: Rolle des KI-Systems klären.

- Explicit: Genaue Erklärungen geben.

- Parameters: Deutlich machen, wie die Antwort ausfallen soll.

Ein weiteres häufig zitiertes Framework bezieht sich ebenfalls auf die einzelnen Schritte, mit denen KI-Systeme zu guten Ergebnissen gebracht werden können, insbesondere bei der Formulierung von Mega-Prompts. Es orientiert sich dabei an der Anatomy eines ChatGPT Mega-Prompts, wie sie von Rob Lennon in einem Post auf der Plattform X beschrieben wurde (ders. 2023).

- Rollenzuweisung: Versetzen der KI in eine spezifische Rolle.

- Arbeitsauftrag: Formulieren einer klaren und präzisen Aufgabe.

- Kriterien und Beispiele: Benennen weiterer Bezüge.

- Zielstellung: Hervorheben des übergeordneten Ziels.

- Angaben zum Format: Angeben von Hinweisen zur gewünschten Länge, zum Tonfall und zu anderen formalen Aspekten.

- Refinement: Optimieren des Outputs durch gezieltes Feedback, um ein möglichst präzises und relevantes Ergebnis zu erzielen.

Wer noch weitere Frameworks vergleichen will, findet auf dem Blog von Thomas Hutter (ders. 2024) neun zusätzliche Akronyme, mit denen Prompts für unterschiedliche Zielsetzungen strukturiert aufgebaut werden können.

Probleme beim Prompting

Natürlich kann es auch trotz strukturierter Anleitungen dazu kommen, dass Prompts nicht zum gewünschten Ergebnis führen. In der Praxis zeigt sich, dass meist einer oder mehrere der folgenden Aspekte dafür verantwortlich sind.

- Missverständliche Prompts: Unklare oder zu vage formulierte Prompts können zu missverständlichen oder ungenauen Antworten führen. Wenn die Anweisungen nicht präzise genug sind, besteht die Gefahr, dass die KI den Kontext oder die Absicht des Prompts falsch interpretiert.

- Unklare Zielformulierung: Ein häufiges Problem beim Prompting kann eine ungenaue oder unklare Zielformulierung sein. Wenn das gewünschte Ergebnis nicht klar definiert ist, besteht die Gefahr, dass die KI keine zielgerichteten Antworten liefert. Eine präzise Zielformulierung ist entscheidend, um sicherzustellen, dass der generierte Output den Erwartungen entspricht und den gewünschten Zweck erfüllt.

- Fehlende Kontextualisierung: Wenn relevante Informationen oder Hintergrundwissen im Prompt fehlen, kann dies die Qualität der generierten Antworten beeinträchtigen. Die KI könnte wichtige Aspekte übersehen oder eine Antwort liefern, die nicht vollständig den Erwartungen entspricht.

- Überforderung durch die Vielzahl an Eingabe-Möglichkeiten: Die Vielzahl an möglichen Eingaben und Anpassungen kann insbesondere für Einsteiger*innen überfordernd sein. Wenn zu viele Optionen zur Verfügung stehen, kann es schwierig sein, den richtigen Ansatz zu wählen oder den Prompt gezielt zu verfeinern. Dies kann dazu führen, dass man sich in Details verliert und den Überblick über das eigentliche Ziel des Prompts verliert.

- Zeitaufwand: Die Entwicklung von guten Prompts kann zeitaufwendig sein, insbesondere wenn iteratives Prompting notwendig ist. Für Lehrkräfte, die ohnehin einen vollen Arbeitsplan haben, kann dies eine zusätzliche Belastung darstellen.

Hilfreiche Unterstützung

Angesichts der großen Herausforderungen beim manuellen Prompting verweisen die Autor*innen des Prompt Reports darauf, dass in der Automatisierung von Prompting-Prozessen (z.B. durch eine automatisierte Prompt-Optimierung) erhebliches Potenzial zu sehen sei. Solche Automatisierungsformen sind bei großen Sprachmodellen bereits implizit zu finden, z.B. indem der Kontext von Eingaben und deren Sprachmuster interpretiert werden. Explizites und automatisiertes Optimieren von Prompts dürfte zudem nur eine Frage der Zeit sein und natürlich können KI-Systeme auch jetzt schon darum gebeten werden, einen umfangreichen und präzisen Prompt aus Stichwörtern und Ideen zu generieren, z.B. durch iteratives Prompting.

Darüber hinaus gibt es aber auch noch weitere Unterstützungs-Werkzeuge, die dabei helfen, das eigene Prompting zu optimieren.

- Prompt-Baukasten: Der Kreidezeit-Blog (Weller 2024) bietet einen Prompt-Baukasten an, der es ermöglicht, Prompts anhand einer Schritt-für-Schritt-Anleitung zu erstellen. Dieser Aufbau ähnelt einem Fragesystem, bei dem die Antworten zu einem Prompt nach dem CRAFT-Framework zusammengeführt werden.

- Prompt-GPT: Ein weiteres interaktives Hilfswerkzeug stellt der GPT „Der Prompt Architekt“ von Lucca Spohn dar (ders. 2024). Dabei handelt es sich um eine öffentlich zugängliche, individualisierte Version von ChatGPT, die darauf trainiert wurde, bei der Entwicklung von Prompts zu helfen.

- Prompt-Kataloge: Eine alternative Möglichkeit bietet der Rückgriff auf bereits vorformulierte Prompts in Prompt-Katalogen. Diese Kataloge enthalten eine Vielzahl von Prompts für unterschiedliche Einsatzgebiete, die per Copy-and-Paste direkt eingesetzt werden können. Auf der Webseite AI for Education finden sich beispielsweise zahlreiche Prompts, die auf einer interaktiven Web-Oberfläche zusammengestellt sind. Zwar sind diese Prompts auf Englisch verfasst, doch können sie dank der Übersetzungsfähigkeiten von LLM-Chatbots problemlos auch für deutschsprachige Anliegen genutzt werden (vgl. AI for Education 2023). Darüber hinaus hat Manuel Flick zahlreiche Prompts in seinem kostenlosen ChatGPT-Guide für Lehrkräfte zusammengestellt (ders. 2024)[4].

Versierte Koaktivität zwischen Mensch und Maschine

Die Ständige Wissenschaftliche Kommission der Kultusministerkonferenz (SWK) erkennt in der „versierten Koaktivität“ mit Large Language Models eine zentrale Zukunftskompetenz (dies 2023, S. 4). Damit soll zum Ausdruck gebracht werden, dass es perspektivisch noch um ein wenig mehr als das Formulieren guter Prompts geht. Wichtiger ist das Erproben sinnvoller Möglichkeiten der immer bedeutsamer werdenden Mensch-Maschine-Interaktion. Für Lehrkräfte heißt das zweierlei: Zum einen sollte Prompting als Technik verstanden und geübt werden. Es kann hilfreich sein, gute Prompts abzuspeichern und eine eigene oder kollaborativ geführte Prompt-Sammlung anzulegen. Zum anderen geht es um Routinen im dialogischen Miteinander mit LLM-Chatbots, z.B. beim iterativen Entwickeln eines bestimmten Outputs. Der Chatbot nimmt bei diesem Ping-Pong die Rolle des Co-Entwicklers ein.

Dass Prompting nicht nur eine einzelne Kompetenz darstellt, sondern sich durch verschiedene Teile einer umfassenden KI-Kompetenz zieht, zeigt sich auch bei einem Blick auf den AI Comp, ein Kompetenzmodell für Future Skills in einer durch KI geprägten Lebenswelt. Dieser Kompass wurde von Next Education in Kooperation mit dem KI-Campus herausgeben und basiert auf einer empirischen Studie, bei der über 1600 Personen befragt wurden. Prompting gehört hier als eine Art Querschnittskompetenz mindestens zur „Aktivitätskompetenz“, der „Systemdesignkompetenz“, der „Problemlösekompetenz“ und zur „Aktiven Steuerungsfähigkeit“ im Umgang mit KI-Systemen (vgl. Ehlers et al. 2023).

Prompting als Fortbildungsthema

Damit Lehrkräfte diese Fähigkeiten trainieren können, sollte Prompting zum Gegenstand von Fortbildungen gemacht werden. Ein interessantes und möglicherweise zukunftsfähiges Format stellen Promptathons (Kombination aus Prompt und Marathon) bzw. Prompt-Battles dar. Erstere folgen der Idee, dass Teilnehmende innerhalb einer bestimmten Zeit kreative Prompts entwickeln, um vorgegebene Aufgaben zu lösen. Die Aufgaben können im Stile eines Barcamps aus den Reihen der Anwesenden gepitcht und ausgewählt werden. Die Ergebnisse werden am Ende präsentiert. Bei einem Promptathon wird zudem in Teams gearbeitet – es handelt sich also um ein PEER-Learning-Format. Beim Prompt-Battle hingegen treten Einzelpersonen gegeneinander an und stellen ihr Können beim Formulieren von Prompts unter Beweis. Dazu bekommen sie eine Aufgabe gestellt, die sie in einer bestimmten Zeit lösen müssen. Das kann eine textbezogene „Challenge“ sein, anschaulicher sind jedoch Aufgaben zum Nachbauen oder Generieren von kreativen Bildern (vgl. Robes/Kirchner 2024).

Prompting bei bildgenerierenden KI-Systemen

Apropos Bilder: Wer vermutet, dass die Frameworks und Ansätze für zielführendes Prompting auch für bildgenerierende Systeme gelten, der liegt leider falsch. Hier gibt es schon deshalb keine allgemeingültigen Anleitungen, weil jedes Bild-KI-Tool anders funktioniert und auf Eingaben anders reagiert. Bei ChatGPT bzw. DALL-E 3, der Bild-KI von OpenAI, können Bilder in einem iterativen Dialog-Prozess entwickelt, verfeinert und auch bearbeitet werden (z.B. mit der Inpaint-Funktion). Andere Systeme wie Ideogram bieten nur eine einmalige Eingabe des Prompts, der jedoch nur aus zentralen Begriffen oder einzelnen Gedanken bestehen muss, da die Software anschließend im Hintergrund das Ausformulieren des Prompts übernimmt (= Autoprompting). Hier gilt es auszuprobieren, erfolgreiche Bilder-Prompts nachzubauen und/oder den Arbeiten bestimmter Personen zu folgen, die sich mit künstlerischem und/oder mit bildungsbezogenem Schwerpunkt auf KI-Bilder spezialisiert haben (z.B. Michaela Kühl oder Alexander Esau).

Fazit

Das Formulieren guter Prompts ist nach wie vor entscheidend, um generativer KI zielführende Ergebnisse zu entlocken. Neben der Orientierung an Frameworks ist es hilfreich, die Grundlagen des Prompt-Engineering zu kennen. Zentral ist, dass die Qualität des Outputs wesentlich von der Formulierung der Prompts und den bereitgestellten Informationen abhängt. Am meisten Erfolg haben Lehrkräfte dann, wenn Prompts mit genauen Erklärungen und Beispielen und mit der Bitte um eine Schritt-für-Schritt-Anleitung versehen werden. Alles andere ist dann Übung, der Aufbau von Erfahrungswissen, das Abspeichern und Teilen guter Prompts und die Entwicklung neuer Arbeitsroutinen, bei denen KI-Systeme sinnvoll und zeitsparend eingesetzt werden können.

Update zum Prompting bei neueren Reasoning-Modellen (2/2025)

Mit den neuen Reasoning-Modellen (GPT o4/o4-mini/o4-mini-high, Flash von Google, R1 von DeepSeek etc.) verändern sich das Verhalten der LLM-Chatbots und damit auch die Anforderungen an das Prompting. Während klassische Modelle (GPT 4o etc.) klare Rollenbeschreibungen, Schritt-für-Schritt-Anleitungen und eine präzise Aufgabenformulierung benötigen, sind Reasoning-Modelle auf komplexe, mehrdeutige oder logisch verknüpfte Fragestellungen spezialisiert. Sie können kausale Zusammenhänge herstellen, vielschichtige Planungen vornehmen und selbst mit unkonkreteren Aufgaben umgehen.

Frühere Modelle profitieren besonders von eindeutigem Kontext, konkreter Zielsetzung und klarer Promptformatierung (siehe oben), um Texte zu generieren, Ideen zu sammeln oder Inhalte umzuformulieren. Welches Modell mit welcher Prompting-Strategie passt, entscheidet man am besten nach dem Einsatzgebiet: Für tiefgehende Analysen und komplexe Aufgaben lohnt sich der Einsatz von Reasoning-Modellen, während klassische Modelle für schnelle, strukturierte Textarbeiten oder Brainstormings bestens geeignet sind.

In Bezug auf die oben beschriebenen Frameworks lässt sich aktuell Folgendes feststellen: Die strikte Einhaltung der Anleitungen ist bei Reasoning-Modellen nicht mehr nötig, schadet bei typischen schulbezogenen Anwendungsfällen in der Regel aber auch nicht. Kontext und Ziele sind ohnehin weiter notwendig, Rollenbeschreibungen, Beispiele und Schritt-für-Schritt-Anleitungen sind nicht mehr erforderlich. Stattdessen können die Fähigkeiten zur Mehrdimensionalität der Reasoning-Modelle gezielt genutzt werden. Eine umfassende Anleitung für Reasoning-Prompts könnte wie folgt aussehen. Die relevantesten Schritte sind farblich hervorgehoben, die anderen Schritte (eher) optional.

- Kontext und Ziel definieren

Beschreibe das Problem oder die Fragestellung so präzise wie nötig. - Aufgabe klar umreißen

Formuliere den Kern der Aufgabe: „Analysiere …“, „Finde mögliche Ursachen für …“, „Plane eine Strategie für …“. - Mehrdimensionale Fragestellungen anregen

Baue zusätzliche Aspekte ein, um komplexe Zusammenhänge zu erschließen. Stelle etwa hypothetische Szenarien („Was wäre, wenn …?“) oder fordere konkrete Beispiele an. - Lösungswege/Denkprozesse strukturieren

Bitte das Modell, den Denkprozess offenzulegen. Etwa durch Aufforderungen wie „Zeige deine Annahmen und leite daraus die einzelnen Schritte ab“ oder „Gehe schrittweise vor und erläutere die Zwischenergebnisse“. - Zwischenschritte und Prüfung

Ermutige das Modell, eigene Teillösungen zu überprüfen und mögliche Fehlerquellen zu benennen. Zum Beispiel: „Analysiere die bisherigen Schritte und überprüfe die Plausibilität deiner Annahmen.“ - Alternativen einbeziehen

Bitte das Modell, unterschiedliche Ansätze oder Perspektiven in Erwägung zu ziehen: „Gibt es andere mögliche Erklärungen?“ oder „Vergleiche mehrere Lösungsstrategien und entscheide dich für die plausibelste.“ - Finales Fazit oder Handlungsanweisung

Fordere abschließend eine kompakte Zusammenfassung, ein Fazit oder eine konkrete Handlungsempfehlung an: „Fasse die wichtigsten Erkenntnisse zusammen“ oder „Formuliere eine umsetzbare Strategie.“ - Prompt-Iterationen

Passe den Prompt bei Bedarf an, wenn das Ergebnis noch nicht zufriedenstellend ist.

Lesetipp für alle, die noch tiefer in die Welt komplexer Prompts eintauchen wollen:

Kaufmann, Sven (2024): KI: Fortgeschrittenes Prompting für Lehrkräfte. Innovative Strukturen, Techniken und Praxisbeispiele für den digitalen Bildungsalltag. Printed in Poland by Amazon Fulfillment.

Anmerkung zu diesem Beitrag: Der Artikel wurde ursprünglich für IQESonline verfasst und im Herbst 2024 hier veröffentlicht.

Quellenverzeichnis und Links

- Agarwal et al. (2024): Many-Shot In-Context Learning. Google DeepMind URL: https://arxiv.org/pdf/2404.11018(zuletzt aufgerufen am 1.9.2024).

- AI for Education (2023): GenAI Chatbot Prompt Library for Educators. URL: https://www.aiforeducation.io/prompt-library (zuletzt aufgerufen am 1.9.2023).

- Bastian, M (2024): Der „Promt Report“ ist ein umfassender Prompting-Überblick mit kuriosen Erkenntnissen. URL: https://the–decoder-de.cdn.ampproject.org/c/s/the-decoder.de/der-prompt-report-ist-ein-umfassender-prompting-ueberblick-mit-kuriosen-erkenntnissen/?amp=1 (zuletzt aufgerufen am 1.9.2024).

- Ehlers, U.-D. (2023). AICOMP – Future Skills für eine durch KI geprägte Welt. URL: https://next-education.org/downloads/2023-11-21-AIComp-FutureSkills-Modell.pdf (zuletzt aufgerufen am 1.9.2024).

- Flick, M. (2024): Der ChatGPT-Guide für Lehrkräfte. URL: https://www.manuelflick.de/chatgpt-guide (zuletzt aufgerufen am 1.9.2024).

- Hutter, T. (2024): 9 PROMPT FRAMEWORKS FÜR CHATGPT / GEMINI / COPILOT. URL: https://www.thomashutter.com/9-prompt-frameworks-fuer-chatgpt-gemini-copilot/ (zuletzt aufgerufen am 1.9.2024).

- Lennon, R. (2023): Anatomy of a ChatGPT Mega-Prompt. URL: https://x.com/thatroblennon/status/1615104249192488980 (zuletzt aufgerufen am 1.9.2024).

- OpenAI (2024): Prompt engineering. URL: https://platform.openai.com/docs/guides/prompt-engineering (zuletzt aufgerufen am 13.9.2024).

- Robes, J./Kirchner, M. (2024): Leitfaden für die Durchführung eines Promptathons. URL: https://colearn.de/wp-content/uploads/2024/07/2024_Leitfaden_Promptathon_v1_1-1.pdf (zuletzt aufgerufen am 1.9.2024).

- Schulhoff et al. (2024): The Prompt Report: A Systematic Survey of Prompting Techniques. URL: https://arxiv.org/pdf/2406.06608 (zuletzt aufgerufen am 1.9.2024).

- Schulz, R. (2024): Prompt Engineering für textgenerierende KI im Unterricht einsetzen. Aufzeichnung einer Online-Veranstaltung vom 15.4.2024. URL: https://www.youtube.com/watch?v=yvyK3D9D4GU (zuletzt aufgerufen am 1.9.2024).

- Spohn, L. (2024): Der Prompt Architekt. URL: https://chatgpt.com/g/g-MPy8h1057-der-prompt-architekt (zuletzt aufgerufen am 13.9.2024).

- Ständige Wissenschaftliche Kommission der Kultusministerkonferenz (SWK) (2023): Large Language Models und ihre Potenziale im Bildungssystem. Impulspapier der Ständigen Wissenschaftlichen Kommission (SWK) der Kultusministerkonferenz. URL: https://www.kmk.org/fileadmin/Dateien/pdf/KMK/SWK/2024/SWK-2024-Impulspapier_LargeLanguageModels.pdf

- Weller, A. (2024): CRAFT – interaktives Prompt Engineering. Nach einem Konzept von Vera Cubero – North Carolina Department of Public Instruction. URL: https://kreidezeit.kiwi/gpt/craft.html (zuletzt aufgerufen am 1.9.2024).

- Xu et al. (2024): Re-Reading Improves Reasoning in Large Language Models. URL: https://arxiv.org/pdf/2309.06275(zuletzt aufgerufen am 13.9.2024).

[1] Das am 13.9.2024 vorgestellte ChatGPT Modell ChatGPT o1 wurde speziell darauf trainiert, länger „nachzudenken“ und derartige Gedankenketten zu durchlaufen. So zerlegt es komplexe Aufgaben selbstständig in Einzelschritte.

[2] Weitere Studien zu KI und Prompting sind im Beitrag „KI-Forschung“ gesammelt und verlinkt.

[3] Es ist darauf zu achten, dass die Prompt-Empfehlungen für ein Sprachmodell nicht zwangsläufig auch für andere Modelle gelten, da sich die unterschiedlichen Systeme anders „verhalten“.

[4] Lehrkräfte, die über eine fobizz-Lizenz verfügen, können auch das KI-Promptlabor nutzen. Hier wird die Prompteingabe durch vorkonfigurierte und auf ein spezifisches Ziel hin optimierte Eingabemasken erleichtert.

Veröffentlicht am 21. Januar 2025

I truly appreciate your technique of writing a blog. I added it to my bookmark site list and will

sitenizi takip ediyorum makaleler Faydalı bilgiler için teşekkürler